Le « biais algorithmique » (en anglais algorithmic bias) signifie : une IA ou un programme informatique prend des décisions qui défavorisent ou favorisent certains groupes. Cela ne se produit pas parce que la technologie est « malveillante », mais parce qu’elle a appris à partir de données qui contiennent déjà des préjugés humains.

Un préjugé est une opinion préconçue sur des personnes, des groupes ou des situations, souvent sans bien les connaître. Ces jugements reposent souvent sur des stéréotypes ou sur des informations incomplètes – et peuvent être injustes. Lorsque les ordinateurs sont entraînés à partir de ces opinions, ils les reproduisent.

Comment cela se produit-il ?

- Données unilatérales

Si une IA est par exemple principalement entraînée avec des informations provenant d’un groupe de population spécifique, elle fonctionnera moins bien pour d’autres groupes.

Exemple : les programmes de reconnaissance faciale identifient souvent les visages à peau claire plus facilement que ceux à peau foncée – car ils ont été entraînés avec davantage de photos de personnes à peau claire. Des études comme Gender Shades, menée par deux chercheuses du MIT, ont montré que les logiciels commerciaux d’analyse faciale présentent des taux d’erreur beaucoup plus élevés pour les femmes à peau foncée que pour les hommes à peau claire – parfois jusqu’à sept fois plus. Cela crée un risque d’identification erronée et d’impacts discriminatoires.

- Renforcement d’inégalités existantes

Lorsqu’un système apprend à partir de schémas et d’inégalités passées, il peut les répéter – et même parfois les amplifier.

Exemple : le « Predictive Policing » envoie davantage de forces de police dans des quartiers où il y a déjà eu de nombreuses arrestations – ce qui conduit à encore plus d’arrestations dans ces quartiers.

Ou encore :

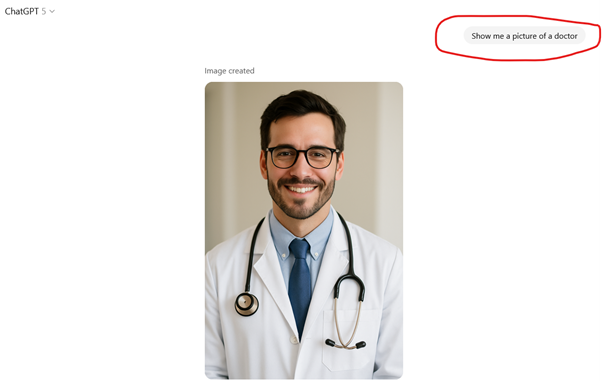

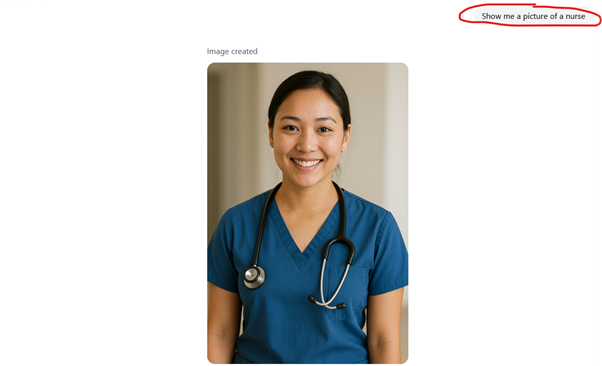

Une vaste étude de mars 2025 portant sur plus de 3,2 millions d’images générées par 5 grands modèles d’IA générative, a confirmé que les générateurs d’images reproduisent les rôles de genre traditionnels. Ainsi, par exemple, les métiers du soin sont majoritairement représentés par des femmes, alors que les activités techniques ou financières sont représentées par des hommes. Ce type d’images peut renforcer inconsciemment des stéréotypes et influencer les choix futurs des enfants et adolescents.

- Décisions des développeurs

Les personnes qui conçoivent les IA et les programmes informatiques définissent aussi les critères – souvent inconsciemment – de manière à avantager ou désavantager certains groupes. Les intérêts politiques ou économiques peuvent également influencer les informations prises en compte ou ignorées par une IA. Lorsque les équipes de développement manquent de diversité, certaines perspectives ne sont même pas envisagées – ce qui fait que des aspects importants peuvent passer inaperçus.

Comment une IA peut-elle être influencée ou manipulée ?

- Données « manipulées » : des informations fausses ou trompeuses sont volontairement intégrées dans l’entraînement pour modifier les résultats.

- Requêtes biaisées : des requêtes formulées de manière stratégique peuvent orienter l’IA dans une certaine direction.

- Algorithmes des plateformes : les systèmes optimisés pour attirer l’attention mettent souvent en avant des contenus extrêmes ou polarisants.

Ce à quoi les utilisateurs peuvent faire attention

Les utilisateurs n’ont pas besoin d’être des experts en IA pour reconnaître certains risques. Il est utile de :

- Se poser des questions critiques : d’où viennent les informations ? Qui se trouve derrière la technologie ?

- Chercher la diversité : ne pas se limiter à une seule source, mais intégrer différentes perspectives.

- Connaître les limites : l’IA ne fournit pas automatiquement la vérité – elle travaille avec des probabilités et se base sur les données qui lui ont été fournies.

Pourquoi c’est aussi une opportunité

Le biais algorithmique nous rappelle que la technologie ne fonctionne pas en dehors de la société.

Si nous apprenons comment ces systèmes sont créés et influencent notre environnement, nous pouvons :

- les utiliser de manière plus consciente,

- identifier les dérives,

- et faire en sorte que les technologies futures soient plus équitables.

Bien utilisée, l’IA peut contribuer à mettre en lumière des injustices, à lever des barrières et à offrir de meilleures chances à toutes et à tous.

Si vous avez besoin de conseils pour découvrir l’IA étape par étape avec des enfants ou pour encourager la pensée critique, vous pouvez contacter la BEE SECURE Helpline via le formulaire de contact ou par téléphone au 8002 1234.