Viele denken, Computer und künstliche Intelligenz (KI) seien völlig objektiv. Doch das stimmt nicht immer. Auch digitale Systeme können Fehler machen – und manchmal sogar Vorurteile verstärken.

Künstliche Intelligenz ist kein neutrales Werkzeug, das im luftleeren Raum agiert. Sie wird von Menschen geprägt – auf positive wie auch auf problematische Weise. Wenn KI mit vielfältigen und fair ausgewählten Daten trainiert wird, kann sie helfen, gerechtere Entscheidungen zu treffen. In manchen Fällen macht sie sogar menschliche Vorurteile sichtbar und ermöglicht es, diese zu hinterfragen und zu korrigieren. Sie kann Prozesse beschleunigen, Ressourcen gezielter einsetzen und beispielsweise in der Medizin oder in der Bildung wertvolle Unterstützung bieten. Gleichzeitig besteht jedoch die Gefahr, dass sich historische Ungerechtigkeiten in die Daten einschleichen und dadurch in den Ergebnissen widerspiegeln.

Was bedeutet „algorithmische Voreingenommenheit“?

„Algorithmische Voreingenommenheit“ (engl. algorithmic bias) bedeutet: Eine Ki bzw. ein Computerprogrammtrifft Entscheidungen, die bestimmte Gruppen benachteiligen oder bevorzugen. Dies passiert nicht, weil die Technik „böse“ ist, sondern weil sie aus Daten gelernt hat, die bereits menschliche Vorurteile enthalten.

Ein Vorurteil ist eine vorgefasste Meinung über Menschen, Gruppen oder Situationen, oft ohne, dass man sie wirklich kennt. Solche Urteile beruhen häufig auf Stereotypen oder unvollständigen Informationen – und können unfair sein. Wenn Computer mit diesen Meinungen trainiert werden, übernehmen sie sie.

Wie entsteht so etwas?

- Einseitige Daten

Wenn eine KI zum Beispiel vor allem mit Informationen aus einer bestimmten Bevölkerungsgruppe trainiert wird, funktioniert sie für andere Gruppen schlechter.

Beispiel: Gesichtserkennungsprogramme erkennen hellhäutige Gesichter oft zuverlässiger als dunkelhäutige – weil sie mit mehr Fotos von hellhäutigen Menschen trainiert wurden. Studien wie die Gender Shades-Untersuchung von zwei MIT-Forscherinnen zeigen, dass kommerzielle Gesichtsanalyse-Software bei dunkelhäutigen Frauen deutlich höhere Fehlerraten aufweist als bei hellhäutigen Männern – teils um das Siebenfache. Dadurch besteht eine Gefahr von Fehlidentifikation und diskriminierenden Auswirkungen dieser Technologien. - Verstärkung bestehender Ungleichheiten

Wenn ein System aus alten Mustern und Ungleichheiten lernt, wiederholt es diese – und verstärkt sie sogar manchmal.

Beispiel: „Predictive Policing“ schickt mehr Polizei in Viertel, in denen es schon viele Festnahmen gab – und erzeugt so noch mehr Festnahmen dort.

Oder

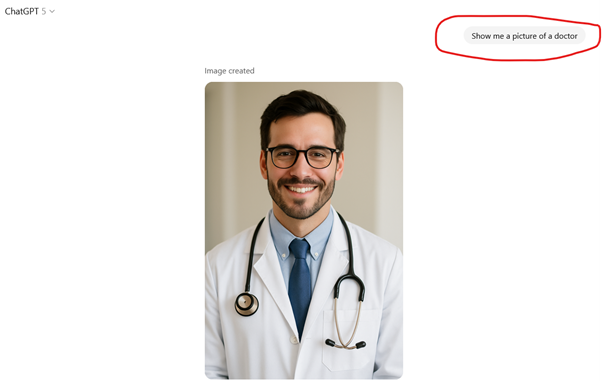

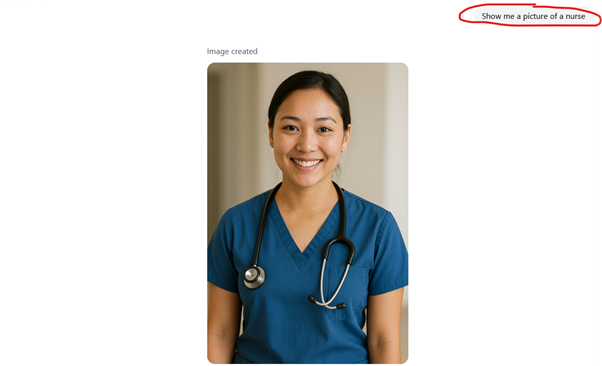

Eine groß angelegte Studie von März 2025 untersuchte über 3,2 Millionen Bilder von 5 führenden Programmen von generativer KI mit Text‑zu‑Bild‑Modellen. Sie bestätigte, dass KI-Bildgeneratoren traditionelle Geschlechterrollen reproduzieren. Pflegeberufe wurden so beispielsweise überwiegend mit Frauen; technische oder finanzielle Tätigkeiten mit Männern dargestellt. Solche Bilder können unbewusst Rollenklischees verstärken und so auch Kinder und Jugendliche vermeintlich in ihrer Zukunftsplanung beeinflussen.

3. Entscheidungen der Entwickler

Auch Menschen, die KI und Computerprogramme entwickeln, legen Kriterien fest – oft unbewusst so, dass gewisse Gruppen im Vorteil oder Nachteil sind. Politische oder wirtschaftliche Interessen können zudem beeinflussen, welche Informationen eine KI bevorzugt und welche weniger berücksichtigt werden. Fehlt es in den Teams, die KI entwickeln, an Vielfalt, werden bestimmte Perspektiven oft gar nicht erst bedacht – mit der Folge, dass wichtige Aspekte unbemerkt bleiben.

Wie kann KI beeinflusst oder manipuliert werden?

- „Vergiftete“ Daten: Es werden gezielt falsche oder irreführende Informationen ins Training eingeschleust, um die Ergebnisse zu verändern.

- Gelenkte Eingaben: Durch geschickt formulierte Anfragen kann man KI in eine bestimmte Richtung lenken.

- Plattform-Algorithmen: Systeme, die auf Aufmerksamkeit optimiert sind, zeigen oft eher extreme oder polarisierende Inhalte.

Worauf man als Nutzer achten kann

Nutzer müssen keine KI-Expertinnen und Experten werden, um Gefahren zu erkennen.

Hilfreich ist:

- Kritisch hinterfragen: Woher kommen die Informationen? Wer steckt hinter der Technologie?

- Vielfalt suchen: Nicht nur eine Quelle nutzen, sondern verschiedene Perspektiven einbeziehen.

- Grenzen kennen: KI liefert nicht automatisch die Wahrheit – sie arbeitet mit Wahrscheinlichkeiten und basiert sich auf Input, der ihr gezielt geliefert wurde.

Warum es auch eine Chance ist

Algorithmische Voreingenommenheit macht uns bewusst, dass Technik nicht losgelöst von der Gesellschaft funktioniert.

Wenn wir lernen, wie solche Systeme entstehen und wirken, können wir:

- sie gezielter und bewusster nutzen,

- Fehlentwicklungen erkennen,

- und dafür sorgen, dass künftige Technologien fairer werden.

KI kann – richtig eingesetzt – helfen, Ungerechtigkeiten aufzudecken, Barrieren abzubauen und allen Menschen bessere Chancen zu geben.

Wenn man Ratschläge dafür braucht, wie man KI zusammen mit Kindern Schritt für Schritt entdecken oder kritisches Denken fördert, kann man sich bei der BEE SECURE Helpline über das Formular oder telefonisch auf folgender Nummer melden: 8002 1234.